Partially Committed

[Review] Zero-Reference Deep Curve Estimation for Low-Light Image Enhancement (CVPR2020) 본문

[Review] Zero-Reference Deep Curve Estimation for Low-Light Image Enhancement (CVPR2020)

WonderJay 2023. 2. 4. 14:13

Zero-Reference Deep Curve Estimation for Low Light Image Enhancement (CVPR 2020)

* Low - light Enhancement

0. Abstract

위 논문은 Zero-Reference Deep Curve Estimation(Zero-DCE) 방법을 제시한다. 해당 방법은 light - enhancement 를 deep network 를 이용한 image-specific curve estimation dask 로 formulate 한다. dynamic range 로 주어진 image 를 조정하기 위해 pixel-wise 및 high-order fcurve 를 추정한다. curve estimation 은 pixel 값 범위, monotonicity, differentiability 를 고려하여 설계되었다. Zero-DCE 는 reference image 에 대해 relaxed assumption 을 할 수 있다는 점에서 좋다. train 시 paired or unpaired data 가 필요하지 않다는 의미이다. 이를 가능하게 하는 것은 non-reference loss function 을 주의깊게 설계했기 때문이다. 본 논문에서 제시하는 방법은 직관적이고 간단한 비선형 curve 로 달성할 수 있다. 단순하지만 일반화된 성능을 보여주며, 다양한 조건에서 잘 작동한다.

1. Introduction

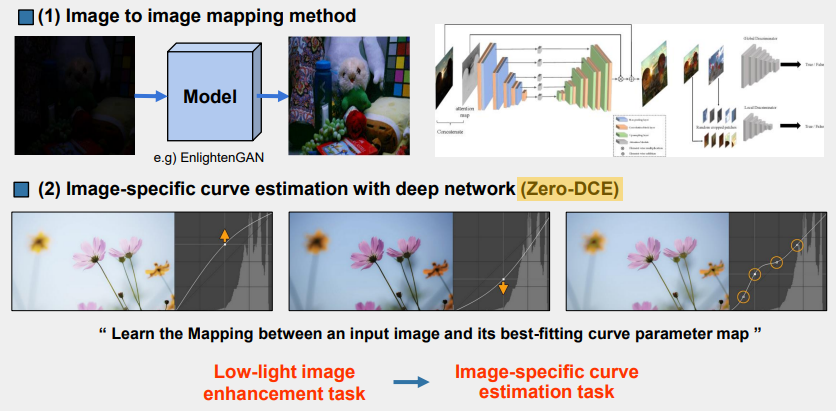

환경 및 기술적 제약에 따라서 조명 조건이 최적화되지 않아서 저조도 이미지가 얻어지는 경우가 많고 이는 물체/얼굴 인식 과 같은 task 에서 잘못된 메세지 전달로 이어진다. 본 연구에서는 deep learning 기반의 Zero-Reference Deep Curve Estimation(Zero DCE) 을 이용하여 low-light image enhancement task 를 해결한다. 균일하지 않고 저조도 조건에 대하여 대처가 가능하다. 이를 위해 image to image mapping 이 아닌 image-specific curve-estimation problem 으로 재구성하여, 저조도 영상을 input 으로 하여 high-order curve 를 output 으로 생성한다. 해당 curve 는 enhanced image 를 얻기 위한 input 의 dynamic range 에 대한 pixel-wise adjustment 에 사용된다. curve estimation 은 인접 픽셀의 contrast 를 유지할 수 있도록 설계되었다.

중요한 것은 해당 방법이 미분 가능하기 때문에 deep convolutional neural network 를 이용하여 curve 의 parameter 을 조정할 수 있다는 것이다. 본 논문에서 제안하는 network 는 가벼우며 보다 robust 하고 accurate 한 dynamic range adjustment 를 위해 반복적으로 적용된다.

해당 방법의 장점은 zero-reference 라는 것이다. CNN 이나 GAN based method 와는 달리 paired or unpainred data 가 training 단계에서 필요하지 않다. 이를 위해 4 가지 종류의 non-reference loss function 을 사용한다. (spatial consistency loss, exposure control loss, color constancy loss, illumination smoothness loss) Zero-DCE 에서는 CNN, GAN based method 와 겨룰 수 있는 성능을 보유한다.(paired or unpaired data 가 없는데도!) Zero-DCE 는 image 의 고유 색상과 디데팅을 유지하며 image 를 밝게한다. CNN based 와 GAN based 방법은 under - enhancement, over-enhancement 를 야기한다.

본 연구의 Contribution 을 요약하면 아래와 같다.

1. 과적합을 피하기 위해 paired 및 unpaired train data 와 독립적인 low-light wnhancement network 를 제안한다. 다양한 조명 조건에 대해서 일반화된 성능을 보인다.

2. 반복적으로 적용하여 pixel-wise 의 higher-order curve 를 설계한다. 이러한 image 별 curve 는 넓은 dynamic range 내에서 mapping 을 효과적으로 수행할 수 있다. (Dynamic range 란 표현할 수 있는 가장 어두운 정도와 가장 밝은 정도의 차이를 의미한다. Dynamic range 가 넓으면 밝은 부분과 어두운 부분을 표현하는 범위가 넓어서 더 많은 정보를 전달할 수 있게 되는 것이다.)

3. image enhancement 성능을 간접적으로 평가하는 task-specific non-reference loss function 을 통해 reference image 가 없을 때 network 를 training 할 수 있는 가능성을 보여준다.

Zero-DCE 방법으로 적은 연산으로도 얼굴 인식과 같은 높은 수준의 시각적인 작업을 개선할 수 있다. GPU 에서 640x480x3 image 의 경우 500 FPS 훈련에 30 분이 소요된다.

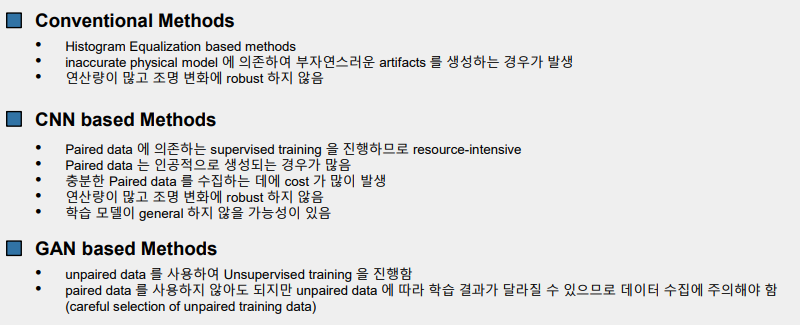

2. Related Work

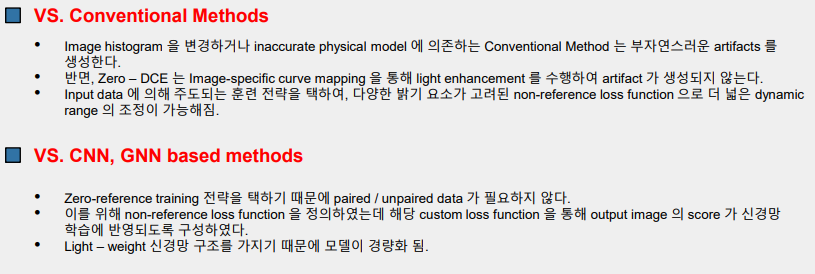

[Conventional Methods] HE-based methods(Histogram Equalization) 는 이미지의 dynamic range 를 확장하여 light enhancement 를 수행한다. 일반적으로 image 를 reflectance 와 illumination 으로 분해하는 Retinex theory 를 사용한다. reflectance 는 일반적으로 모든 조명 조건에서 consistenct 한 것으로 가정하므로 light enhancement 는 illumination estimation problem 으로 바라볼 수 있다. Illumination map 을 estimation 하는 것은 optimization problem 을 해결하는 것이다. histogram distribution 의 변화를 가져오거나 부자연스러운 물리 모델에 의존하는 전통적인 방법과는 달리 Zero-DCE method 는 image-specific curve mapping 을 통해서 enhanced result 를 생성한다. 이러한 전략은 비현실적인 artifcats 를 생성하지 않는다.

Yuan 과 Sun 은 automatic exposure correction method 를 제안하였다. 해당 방법은 주어진 이미지에 대한 S-shape curve가 global optimization algorithm 에 의해 estimation 되고 각각의 segemnted region 은 curve mapping 에 의해 optimal zone 으로 push 된다. 이러한 Yuan and Sun 방법과는 달리 Zero-DCE 는 순수한 데이터 기반 방법으로 non-reference loss function 을 설계함으로써 multiple light enhancement factors 들을 고려하기 때문에 보다 robust 하고 image 의 dynamic range 가 더 넓으며 연산량이 적다.

[Data-Driven Methods] Data-Driven method 는 CNN-based 와 GAN-based method 으로 분류할 수 있다. 대부분의 CNN-based solution 은 paired data 에 의존하는 supervised trainning 을 진행하므로 resource-intensive 하다는 특징이 있다. Paired data 는 automatic light degradation, changing the settings of cameras during data capturing, synthesizing data via image retouching 등을 통해 수집된다. 예를 들어 LL-Net 은 Gamma correction 을 simulation 하도록 훈련된 네트워크으로 LOL dataset 은 LL-Net 으로부터 얻어진 paired low/normal light image data sets 이다.

최근에 Wang et al 은 illumuination map 의 추정에 의한 underexposed photo enhancement network 을 제안하였다. 이 network 는 paired data 로부터 훈련되었다. 이러한 Paired data 를 기반으로 하는 light enhancement solution 은 충분한 paired data 수집에 cost 가 많이 들며, 또한 paired data 생성 시 다소 비현실적이고 인위적인 데이터가 포함될 수 밖에 없다는 점으로부터 비실용적인 방법이라고 추론할 수 있다. 이러한 제약사항은 generalization 성능이 떨어지게끔 만든다. 실제 이미지가 주어지면 다양한 결점이 발생할 수 밖에 없다.

Unsupervised GAN-based methods 는 paired data 를 trainning 해야 한다는 제약사항을 제거한다. EnlightenGAN 이 대표적인 GAN-based pioneer method 으로 low-light images 를 unpaired low/normal light data 로부터 학습한다. EnlightenGAN network 는 정교하게 설계된 discriminator 와 loss function 으로 부터 훈련는데, unsupervised GAN-based solution 특성 상 unpaired training data 를 신중하게 선택해야 좋은 성능을 가져올 수 있다.

본 논문에서 제안하는 Zero-DCE 는 Data-Driven Method 보다 세가지 측면에서 우수하다.

1. zero reference 특성에 의해 paired and unpaired data 가 필요하지 않다.

2. 정교하게 셜계된 non-reference loss function 을 통해서 훈련이 진행되므로 output image 의 quality 를 명백하게 평가할 수 있고, 이 결과는 network learning 에서 반복된다.

3. Zero-DCE 방법은 cost-effective 하다.

이러한 세가지 측면의 장점으로 부터 lightweight network structure 와 effective non-reference loss function 을 구성할 수 있다.

3. Methodlogy

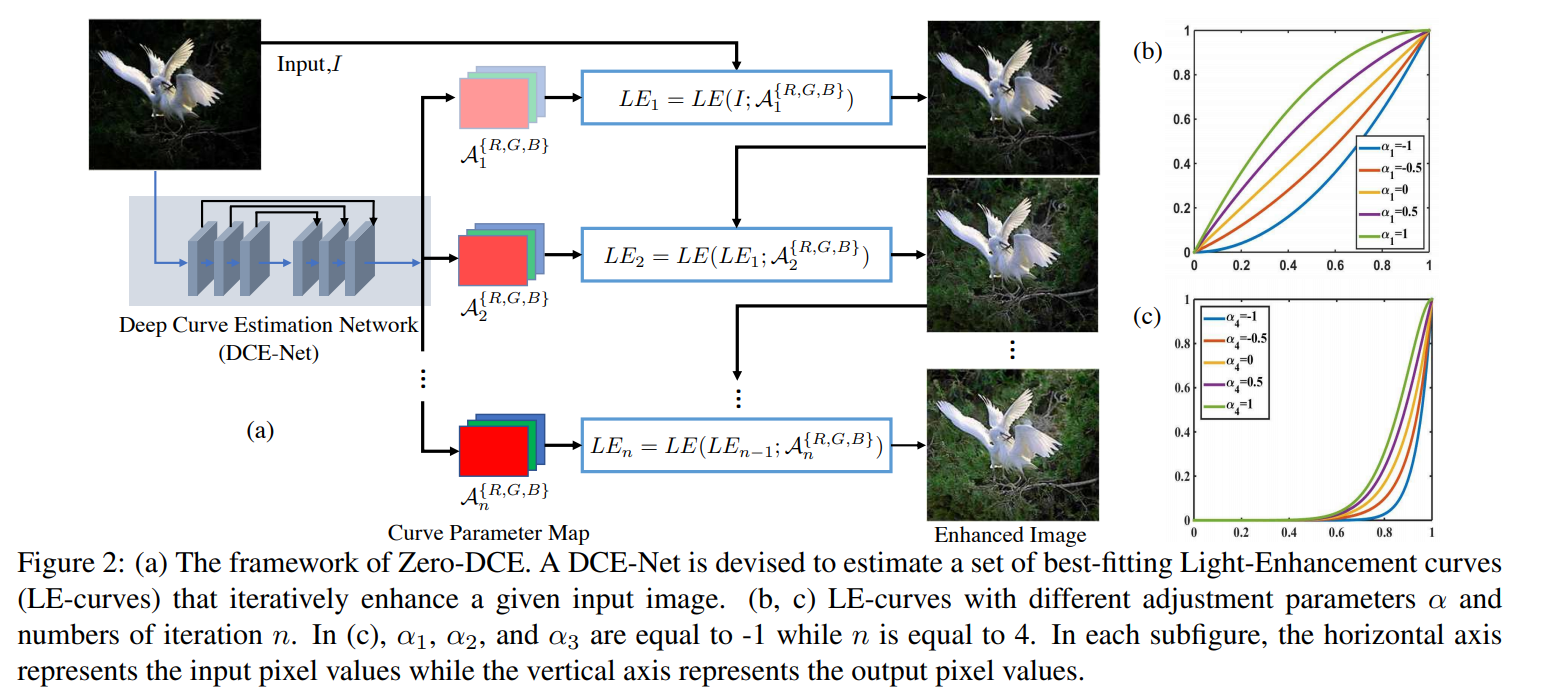

DCE-Net(Deep Curve Estimation Network) 는 주어진 입력 이미지로부터 가장 적합한 Light-Enhancement curve(LE-curve) set 을 estimation 하기 위해 고안된 것이다. enhanced result 를 얻기 위해 curve 를 반복적으로 적용하여 input rgb channel 의 모든 pixel 들을 mapping 한다.

3.1. Light-Enhancement Curve (LE-curve)

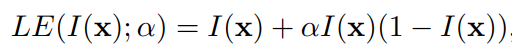

Photo editing software 의 curve adjustment 방식에서 영감을 얻어, low-light image 를 automatically 하게 enhanced version 으로 mapping 하는 curve 를 design 하려고 하였는데, self-adaptive curve parameters 은 input image 에 의해서만 결정되도록 한다. curve 는 아래 3 가지 사항을 만족해야 한다.

1. enhanced image 의 각각의 pixel 값은 normalized range 인 [0, 1] 사이에만 존재해야 한다. 그래야만 overflow truncation 에 의한 정보 유실을 방지할 수 있다.

2. curve 는 monotonous 를 유지해야만 한다. 그래야만 neighboring pixel 간의 차이인 contrast 를 보존할 수 있다.

3. curve 의 형태는 가능한 단순해야 하며 미분가능 해야 한다.(backpropagation)

위 목표의 달성을 위해 아래와 같이 quadratic curve 를 design 하였다.

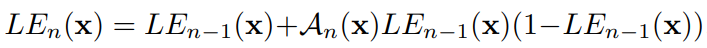

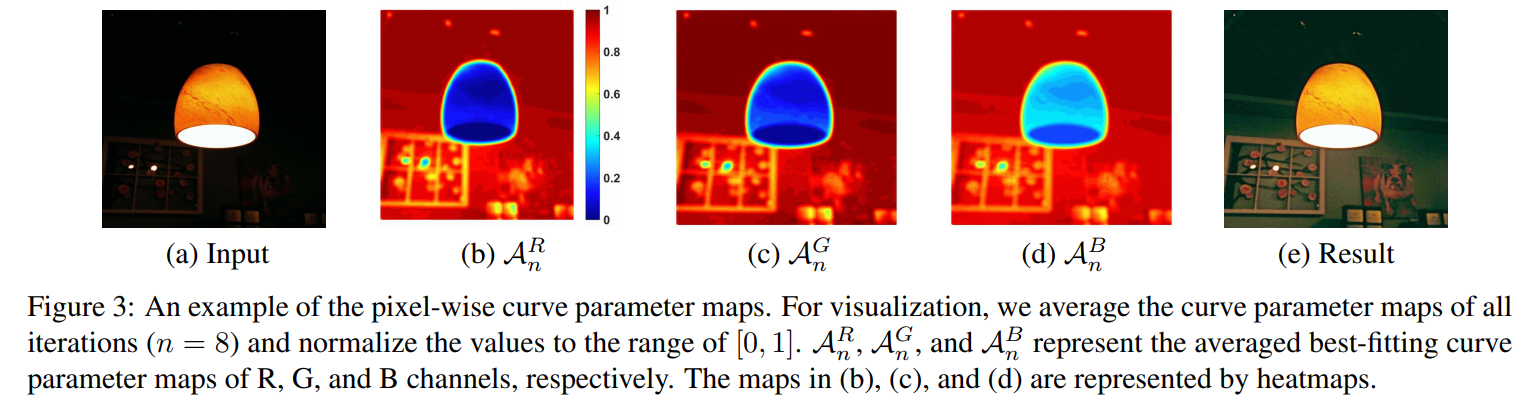

각각의 pixel 은 [0, 1] 로 normalization 되며, 모든 연산은 pixel-wise 로 수행된다. LE-curve 가 illuminiation 채널에 적용하는 것 대신에 RGB channel 에 대하여 분리하여 적용한다. 이는 색상을 보다 잘 보존하여 over-saturation 의 risk(채도가 과해짐) 을 줄인다. a 값에 의해 변하는 LE-curve 의 형태는 아래 그림의 (b) 와 같다. LE-curve 는 input image 의 dynamic range 를 increase 하거나 decrease 할 수 있다. 이는 low-light enhancing 뿐만이 아니라 over-exposure artifact 를 제거하는 효과를 가져오기도 한다.

LE-curve 를 반복적으로 적용할 수 있다면 더욱 low-light 한 condition 에도 적용이 가능하다.

이와 같은 higher-order curve 를 활용하면 더 wide 한 dynamic range 에서 image adjustment 가 가능하다. 유의할 점은 a 값을 조정하는 것은 global adjustment 이다. 이는 local region 에서 over-/under- enhance 를 야기할 수 있다. 이를 피하기 위해 a 값을 pixel-wise parameter 로 설정할 필요가 있다. 각각의 픽셀은 각각의 a 값을 가지고 이에 mapping 되는 curve 를 가지게 된다.

local region 내의 pixel 들은 같은 intensity 및 같은 adjustment curve 를 가진다고 가정하여 enhanced image 도 monotonous 를 유지하게 된다.

위 그림을 보면 input image 의 r,g,b channel 각각에 대하여 예측된 curve parameter map 을 보여주는데, 유사한 tendency 를 가지지만 value 는 각각 다른 것을 확인할 수 있다. 이와 같이 pixel-wise 로 curve mapping 을 통해 enhanced image 를 얻을 수 있게 된다.

3.2. DCE-Net (Deep Curve Estimation Network)

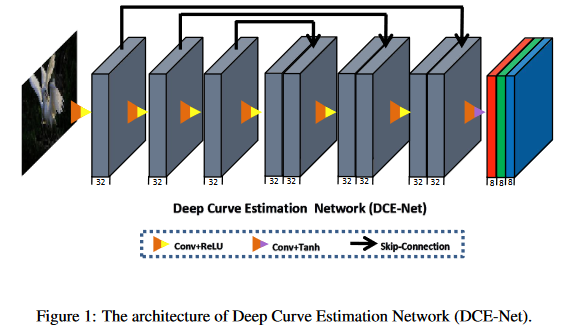

input image 와 best-fitting curve parameter maps 간의 mapping 을 학습하기 위해 Deep Curve Estimation Network(DCE-Net) 을 제안한다. DCE-Net 의 Input 은 low-light image 이고 output 은 pixel 별로 curve parameter maps set 이다. 대칭적으로 연결된 (Symmetrical concatenation) 7 개의 Convolutional layer 로 구성된 CNN 을 사용한다. 각각의 Layer 은 3x3 크기의 kernel 을 stride = 1 로 하여 32 개를 통과시킨 다음 ReLU activation function 에 통과시킨다. 이때 down-sampling 과 batch normalization 을 사용하지 않음으로써 neighboring pixel 의 relation 이 깨지지 않도록 한 것에 유의한다. 마지막 convolutional layer 은 Tanh activation function 을 사용한다. 8 번의 iteration 이 끝나면 24 개의 parameters map 을 얻을 수 있다. 각각의 반복에서 3 개의 채널마다 하나의 parameter map 이 생성되기 때문이다. DCE-Net 의 trainable parameters 은 79,416 개으로 5.21G Flops 으로 연산이 가능한 경량 모델이다. input size 는 256x256x3 이며, mobile 과 같이 제한된 resource device 에서도 사용이 가능하다.

3.3. Non-Reference Loss Functions

Zero-reference 로 DCE-Net 을 학습하기 위해서는 enhanced image 를 평가하는 non-reference loss function 을 정의해야 하며 이를 위해 아래의 4 가지 loss function 을 제안하였다.

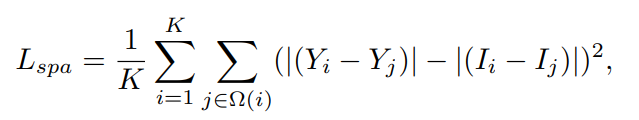

1. Spatial Consistency Loss (L_spa)

: input image 와 enhanced image 간 difference of neighboring regions 을 보존하여 enhanced image 가 spatial coherence 가 유지되도록 한다.

본 논문에서는 local region 의 size 를 4 x 4 로 지정하였지만, 다른 사이즈를 사용하여도 L_spa 는 안정적인 경향이 보인다고 한다.

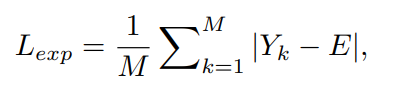

2. Exposure Control Loss (L_exp)

: under-/over-exposed region 을 제한하기 위해 exposure lever 을 L_exp 를 이용하여 control 한다. Exposure control loss 는 average intensity value of local region 과 averawge intensity value of well-exposedness level E 간의 distance 를 측정한다. RGB color space 에서 gray level 을 E 로 설정하였고, 본 논문에서 E 는 0.6 으로 정하였다.

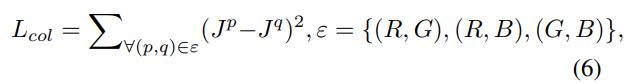

3. Color Constancy Loss (L_col)

: RGB channel 을 평균이 Gray 가 된다는 Gray - World color constancy hypothesis 를 따라, enhanced image 에서 발생할 수 있는 color deviation 을 correction 하는 color constancy loss 를 design 한다. 해당 loss function 은 새로 adjust 된 3 가지 채널 간 관계를 조정해준다.

4. Illumination Smoothness Loss (L_tvA)

: neighboring pixel 간 monotonicity 를 방지하기 위해 illumination smoothness loss 를 각각의 curve parameter map A 에 추가한다.

4. Experiments

Wide dynamic range 에 대한 adjustment 이 발생하도록 low-light image 뿐만이 아니라 over-exposed image 또한 train dataset 으로 포함하였다. EnlightenGAN 의 train 에도 활용 된 SICE(Single Image Contrast enhancement) dataset 의 Part 1(360 multi-exposure sequences) 를 train set 에 포함시킨다. 그리고 3,022 개의 서로 다른 exposure level 을 가진 image 를 random split 하여 2,422 개를 train set 에 사용하고 나머지를 validation set 으로 사용한다. 이때 train input image 는 512x512 로 fix 한다.

NVIDIA 2080Ti 에서 Pytorch 를 이용하여 구현하였고, batch size 는 8 로 설정한다. 각각의 layer 는 mean=0, std=0.02 의 gaussian function 으로 initialization 하였다. optimizer 으로는 ADAM (부가적인 parameter 설정 x)을 사용하였고 learning rate 는 1e-4 로 고정한다. Total loss 에서 W_col 과 W_tvA 는 0.5, 20 으로 설정한다.

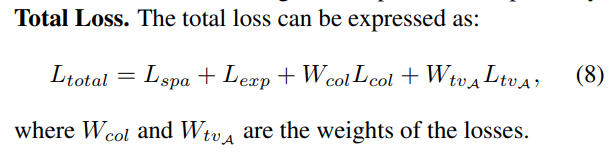

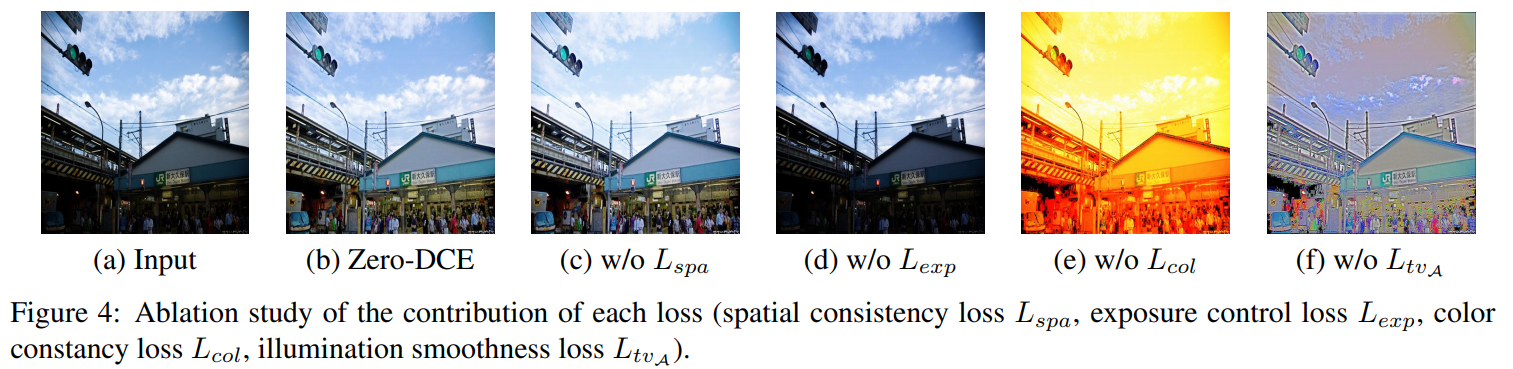

4.1. Ablantion Study

Contribution of Each Loss

각각의 Loss function 이 train 에 미치는 영향을 파악하기 위해 Total Loss 에서 구성을 변경하여 실험을 진행한다.

Spatial consistency loss (L_spa) 를 제거한 뒤 훈련을 진행하면 lower contrast 를 가지게 된다. 이는 L_sap 가 이웃 영역과의 차이를 보존하기 위해 중요한 역할을 수행한다는 것을 시사한다.

Exposure control loss (L_exp) 를 제거한 뒤에 훈련을 진행하면 low-light region 의 recovery 가 발생하지 않는다.

Color constancy loss (L_col) 을 제거하면 색상 변화가 예기치 못하게 발생한다. 이는 rgb channel 간 관계성을 무시하고 curve mapping 이 수행되는 문제를 야기할 수 있다.

Illumination smoothness loss (L_tvA) 를 제거하면 이웃 영역간의 correlation 이 어지럽혀져서 artifact 가 명백하게 발생한다.

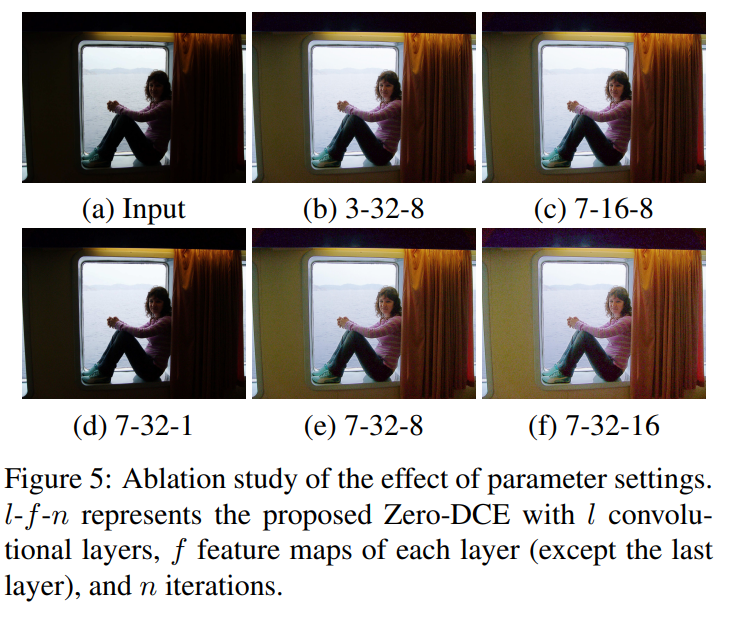

Effect of Parameter Setting

DCE-Net 의 depth(conv layer 개수), width(layer 당 fiter 개수), number of iteration 에 따라 어떠한 효과가 발생하는 지 실험을 진행한다.

(b) : 3 개의 conv layer 만 사용하여도 satisfactory result 를 얻을 수 있었다.

(e) 와 (f) 가 가장 시각적으로 보았을 때 자연스러운데 이로부터 interation 횟수가 어느정도 클 수록 natural exposure 과 proper constrast 를 얻을 수 있음을 알 수 있다.

(d) 에서는 iteration 을 1번만 진행하였다. 이렇게 하면 curve 적용을 1번만 하게 되고 이는 light-enhancement 의 성능저하를 야기한다는 것을 알 수 있다.

* 이러한 실험 결과로부터 7-32-8 을 optimal 한 parameter 로 선택하였다.

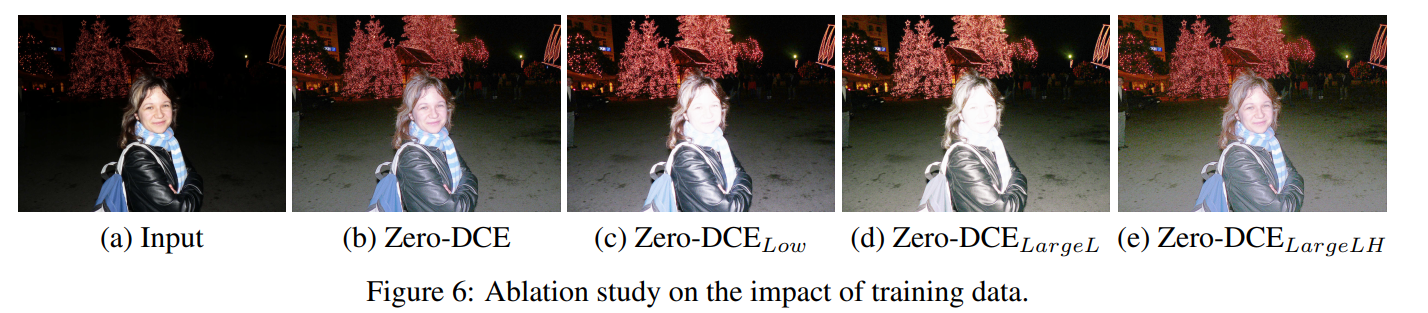

Impact of Training Data

Zero-DCE Network 를 서로 다른 데이터셋을 이용하여 훈련시켜, training dataset 에 따른 impact 를 살펴본다.

* Zero-DCE_Low : 900 개의 low-light image 만을 사용

* Zero-DCE_LargeL : DARK FACE dataset 에서 9,000 장의 unlabeld low light image 를 사용

* Zero-DCE_LargeLH : SICE dataset 에서 Part1, Part2 에서 data augmentation 을 적용한 multi-exposure image 를 사용

위 결과를 보면 over-exposed image 가 포함되지 않는 경우에는 (c) 와 (d) 처럼 input image 에서 원래부터 밝았던 영역은 over-enhance(face 영역) 된다. low-light image 의 개수를 늘리는 것은 이를 해결할 수 있는 솔루션이 아니였다. (e) 와 같이 multi - exposure(노출 상태가 다양) image 를 사용하면 low-light enhancement 성능이 가장 뛰어나는 것을 관찰할 수 있다.

4.2 Benchmark Evaluations

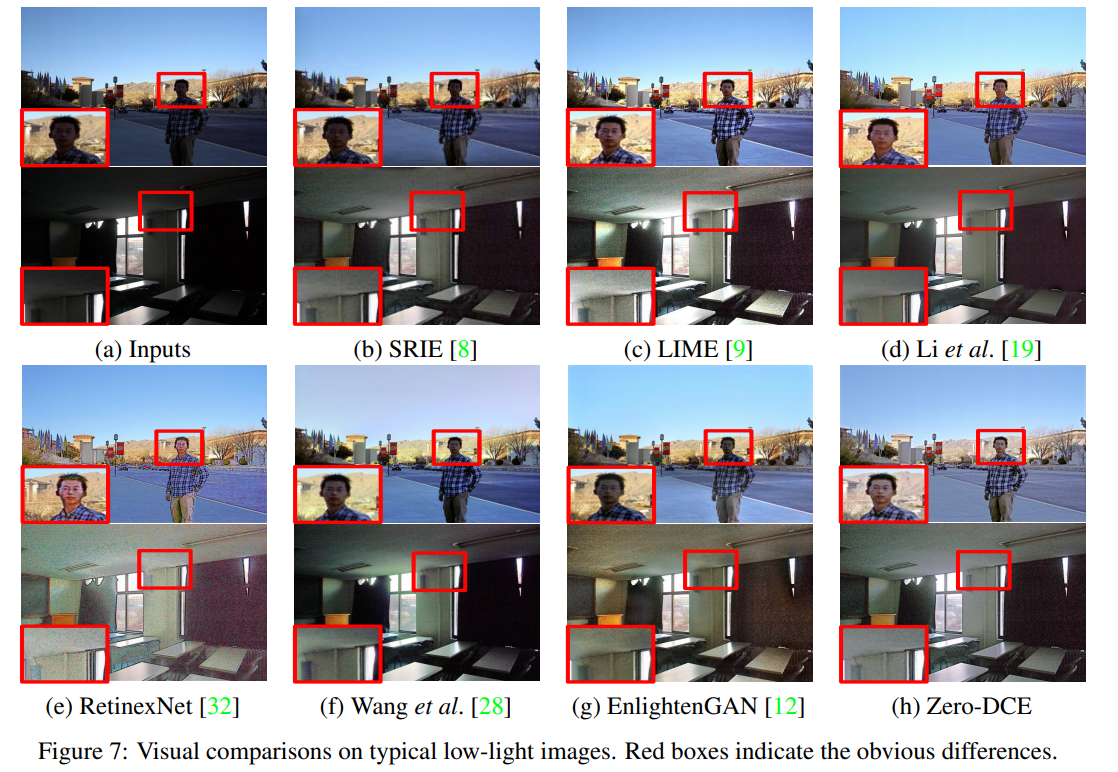

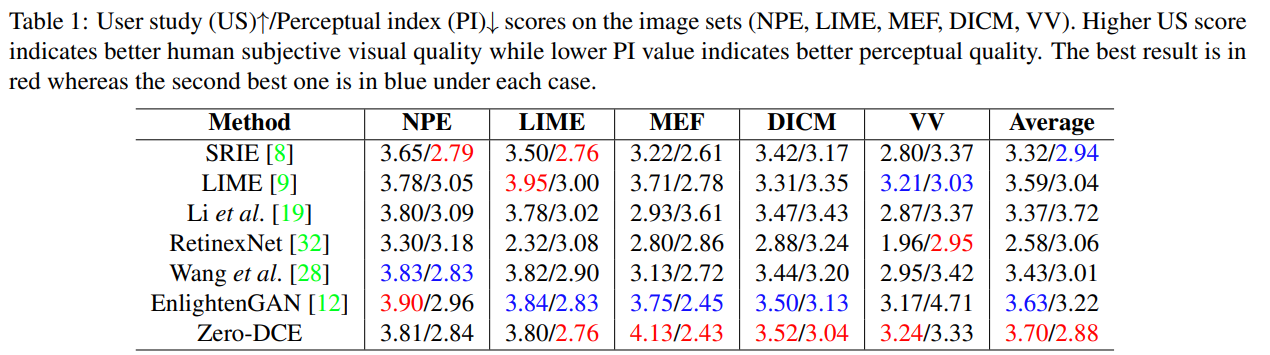

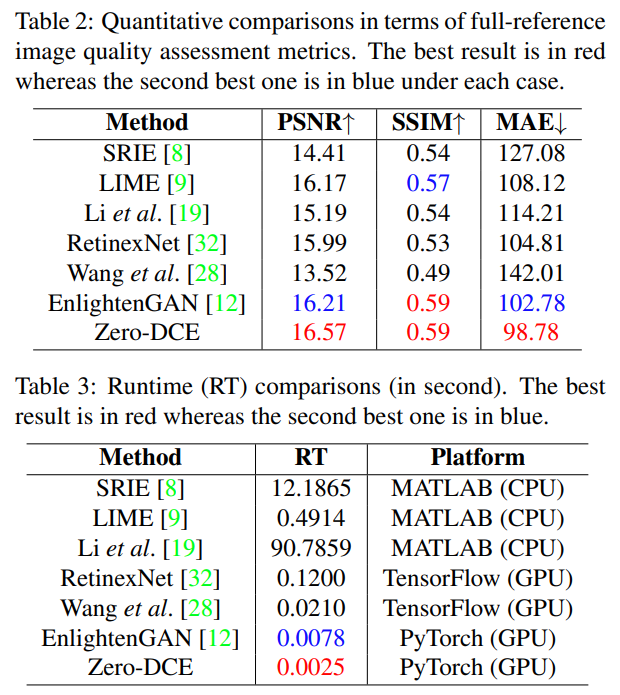

본 논문에서 제안한 Zero-DCE 를 여러 가지 state-of-the-art method 와 비교를 진행한다. 3 가지 conventional methods 인 SRIE, LIME, Li et al 과 2 가지 CNN - based methods 인 RetinexNet, Wang et al 그리고 GAN-based method 인 EnlightenGAN 모델과의 비교를 수행한다.

test image set 은 NPE(Naturalness Preserved Enhancement) 84 images, LIME(Low-light Image Enhancement via illumination Map Estimation) 10 images, MEF(Multi-Exposure Image Fusion) 17 images, DICM 64 images, VV 24 images 를 사용한다.

Zero-DCE model 은 적절한 exposure 과 detail 을 명확하게 살린 반면 SRIE, LIME, Wang et al, EnlightenGAN 은 face 를 명백하게 recovery 하지 못하였다. RetinexNet 은 over-exposed artifacts 를 생산한다.

Zero-DCE model 은 dark region 을 enhance 함과 동시에 input image 의 color 을 보존하였지만 Li et al 은 noise 를 증폭하고 color deviation 을 생산하며 over - smoothe 한다.

Peak Signal-to-Noise Ration(PSNR, dB) 와 Structural Similarity(SSIM), Mean Absolute Error (MAE) metric 을 사용하여 정량적으로 비교하였다. Zero-DCE 는 모든 case 에서 best value 를 달성하였다. (zero-reference 임에도!) Zero-DCE 는 또한 computationally efficient 하다.

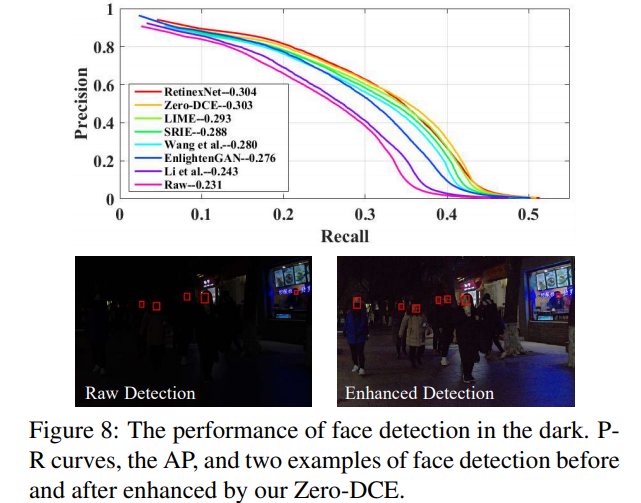

4.2.3 Face Detection in the Dark

DARK FACE dataset 을 이용하여 저조도 환경에서 Face Detection 성능을 비교한다. Face detection 으로는 Dual Shot Face Detector (DSFD) 를 사용한다.

그 결과, RetinexNet 과 Zero-DCE Net 이 가장 Best 한 것을 확인할 수 있다. High recall area 에서는 Zero-DCE Net 이 보다 우수하다. 이와 같이 Zero-DCE 를 이용하여 face 를 lightens up 하면 extremely dark regions 에서도 충분히 정확한 face detection 수행이 가능함을 시사한다.

5. Conclusion

본 논문에서는 low-light image enhancement 를 위한 deep network 인 Zero-DCE Net 을 제안한다. 이는 end-to-end with zero-reference images 로 훈련이 가능하다. low-light image enhancement task 를 image-specific curve estimation problem 으로 바라보고 non-reference loss 를 설계했기 때문에 reference image 가 필요하지 않다. Experiments 들로부터 Zero-DCE 방법이 뛰어난 성능을 보이는 것이 증명되었으며, 향후 연구에서 noise 의 영향을 고려한 hard case 를 해결하기 위한 의미있는 정보를 제안할 수 있도록 지속적으로 탐구할 것이다.

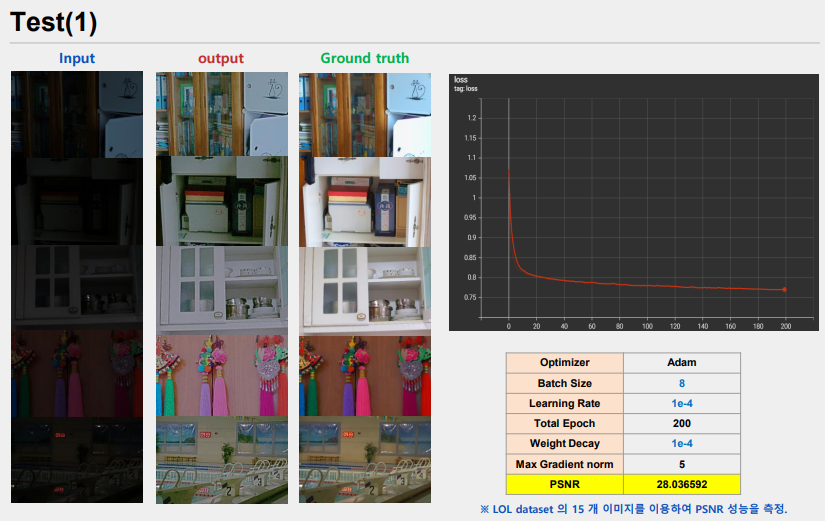

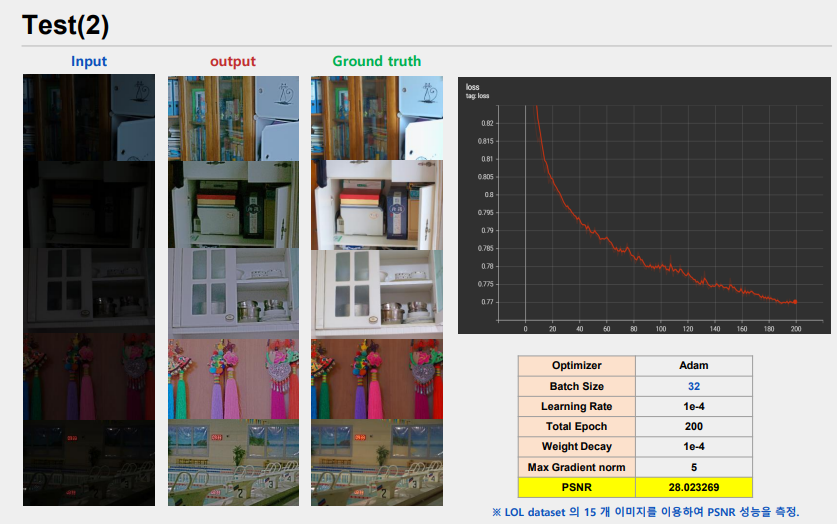

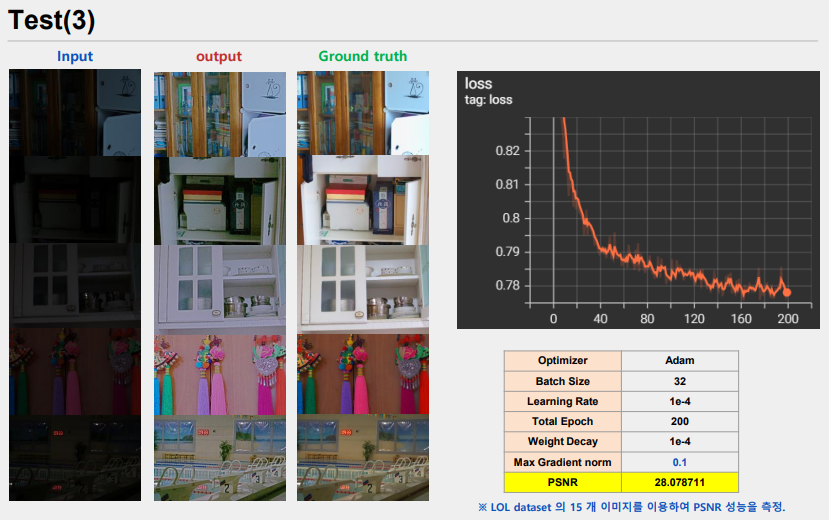

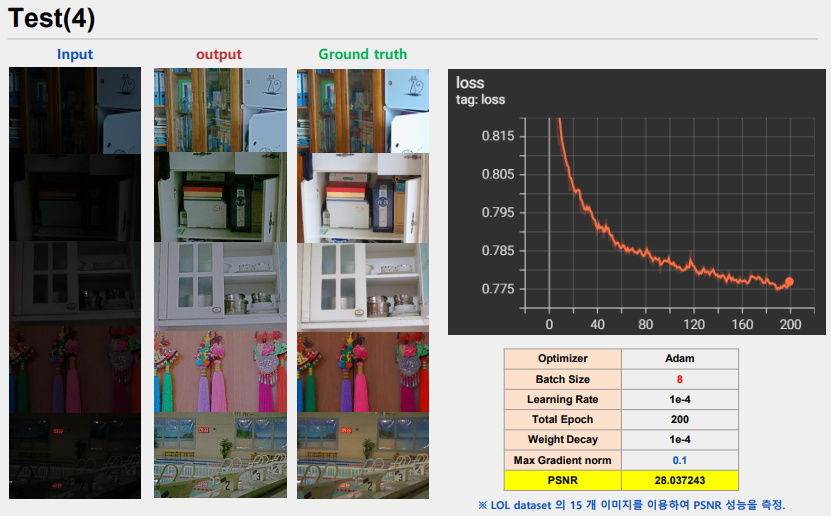

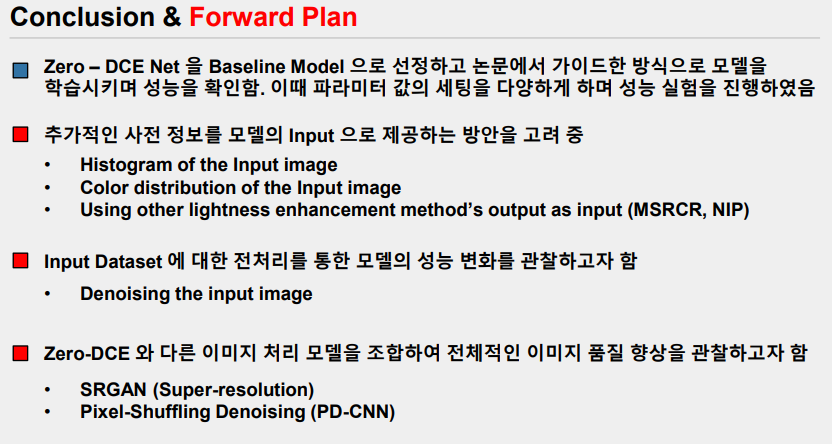

6. Implementation

본 논문에서 제안한 모델인 Zero-DCE 를 구현하고 학습을 진행해보았다.

https://hayunjong83.tistory.com/54

논문리뷰) 어두운 영상의 밝기 조정 : Zero-Reference Deep Curve Estimation for Low-Light Image Enhancement

시선 예측을 위한 사용자 영상 뿐만 아니라 컴퓨터 비전의 다양한 태스크에 쓰이는 입력 영상들은 조명이나 카메라의 노출 변화에 따라 사람의 눈에 보이는 양상이 크게 변할 수 있다. 안정적이

hayunjong83.tistory.com